Modul 3: Vertrauenswürdige KI und KI-Absicherung ⚖

Abschnittsübersicht

-

-

Nach Veröffentlichung der ethischen Leitlinien für den KI-Einsatz und die Entwicklung haben diverse Akteure Ansätze und Initiativen entwickelt um vertrauenswürdige (trustworthy) Systeme zu entwickeln und zu fördern. Vertrauenswürdige KI bezieht sich dabei auf die Entwicklung und den Einsatz von Künstlicher Intelligenz, die zuverlässig, ethisch und sicher ist. Sie sollte so gestaltet werden, dass sie keine ungewollten negativen Auswirkungen auf Gesellschaft, Individuen oder bestimmte Gruppen hat, unter anderem im Hinblick auf Diskriminierung und Ungleichbehandlung. Um diese Vertrauenswürdigkeit zu sichern, werden fortlaufend neue Instrumente, wie Frameworks, Normen, Gesetze und technische Werkzeuge implementiert.

Im Lauf der letzten Jahre haben sich Staaten, NGOs und Unternehmen durch KI-Richtlinien öffentlich zum Thema Ethik in der KI positioniert. Innerhalb der EU zieht sich der Prozess der Gesetzgebung und Normung zur europäischen KI-Verordnung seit 2021.

-

Frameworks

Frameworks existieren, um eine strukturierte und systematische Bewertung von Technologien, wie beispielsweise Künstlicher Intelligenz, zu ermöglichen, um deren Qualität, Sicherheit und ethische Verantwortung sicherzustellen und so Vertrauen in ihre Anwendung und Entwicklung zu fördern.

Ein Beispiel für einen KI-Framework ist der vom Fraunhofer IAIS entwickelte KI-Prüfkatalog. Dieser dient dazu, die Vertrauenswürdigkeit von KI-Anwendungen systematisch zu bewerten. Er umfasst einen vierstufigen Prozess: Risikoanalyse, Festlegung messbarer Zielvorgaben, Maßnahmen entlang des Lebenszyklus und eine Argumentation zur Erreichung der festgelegten Ziele. Der Katalog deckt sechs Dimensionen der Vertrauenswürdigkeit ab, darunter auch Fairness, Transparenz und Sicherheit. Ziel ist es, Entwickler*innen und Prüfer*innen bei der Dokumentation und Evaluierung von KI-Anwendungen hinsichtlich ihrer Qualität und ethischen Anforderungen zu unterstützen.

-

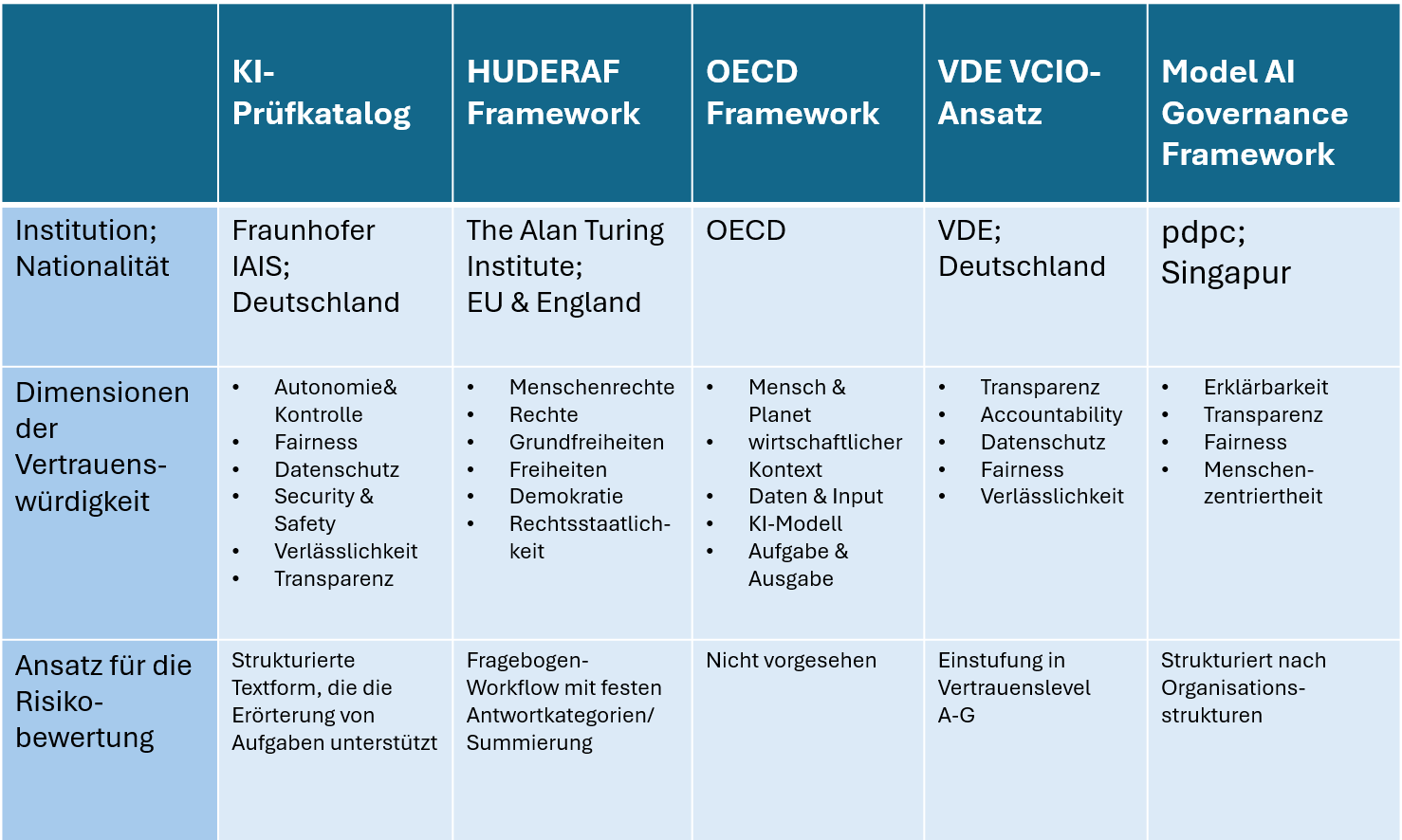

Übersicht: Internationale Frameworks

In Anlehnung an: Schmitz, A., Mock, M., Görge, R. et al. A global scale comparison of risk aggregation in AI assessment frameworks. AI Ethics (2024). https://doi.org/10.1007/s43681-024-00479-6 (CC BY 4.0)

-

Monitoring bezieht sich auf die laufende Überwachung von KI-Systemen während ihres Betriebs, um sicherzustellen, dass sie ethischen Standards entsprechen und keine unerwünschten Verzerrungen erzeugen. Ein konkretes Beispiel hierfür ist Gesichtserkennungssoftware, die oft auf Verzerrungen überprüft wird, um sicherzustellen, dass sie alle demografischen Gruppen gleich behandelt . So zeigte eine Untersuchung von IBM Watson, dass deren Gesichtserkennungssoftware systematische Fehler bei der Identifikation von nicht-weißen Personen aufwies. Durch kontinuierliches Monitoring werden solche Verzerrungen frühzeitig identifiziert und können durch Anpassungen an den Algorithmen oder durch die Integration diverser Trainingsdaten behoben werden. Tools wie Fairness Indicators helfen dabei, die Ergebnisse von KI-Systemen in Bezug auf verschiedene demografische Gruppen zu überwachen und auf Diskriminierung zu überprüfen.

Auditing ist der formelle Prozess der unabhängigen Prüfung von KI-Systemen , um sicherzustellen, dass sie keine Diskriminierung oder Fehler verursachen und regulatorische Anforderungen erfüllen. Ein Beispiel für Auditing findet sich im Bereich der Kreditvergabe, wo KI-gestützte Systeme häufig auf Verzerrungen hin überprüft werden. Im Jahr 2019 zeigte eine Untersuchung des U.S. Consumer Financial Protection Bureau (CFPB), dass einige KI-basierte Kreditvergabesysteme unbewusst bestimmte ethnische Gruppen benachteiligten. Audits helfen, diese Verzerrungen zu erkennen und die Algorithmen entsprechend anzupassen.

Die Zertifizierung von KI-Systemen stellt sicher, dass diese alle erforderlichen ethischen, sicherheitsrelevanten und regulatorischen Standards erfüllen. Ein Beispiel für eine solche Zertifizierung ist das AI Trust Framework von TÜV Rheinland, das KI-Systeme zertifiziert, die internationalen Normen für Sicherheit und Ethik entsprechen. Diese Zertifizierung gibt den Nutzer*innen Vertrauen, dass die Technologie auf faire und transparente Weise funktioniert.

Podcasts-Tipp:

Wie vertrauenswürdig ist KI? Auf dem Weg zu einer KI-Zertifizierung »made in Germany«

https://www.fraunhofer.de/de/mediathek/podcasts/2024/podcast-vertrauenswuerdige-ki.html

-

EU KI-Verordnung

Als Reaktion auf die Bedenken in Bezug auf die ethische Nutzung und die Risken von KI, hat die Europäische Union (EU) mit dem Artificial Intelligence Act (AI Act), welcher einen neuen globalen Standard für die KI-Regulierung darstellen soll, am 1. August 2024 verabschiedet. Das wesentliche Ziel des Gesetzes ist die Erhaltung und der Schutz der Grundrechte, der Demokratie, der Rechtsstaatlichkeit sowie der ökologischen Nachhaltigkeit. Das Gesetz wird bis 2026 vollständig anwendbar sein, wobei Verbote nach sechs Monaten in Kraft treten, Governance-Regeln und Pflichten für allgemeine KI-Modelle nach zwölf Monaten gelten und die Vorschriften für KI-Systeme, die in regulierte Produkte eingebettet sind, nach 36 Monaten wirksam werden. Dabei zielt die Verordnung der EU darauf ab, ein Gleichgewicht zu schaffen zwischen der Innovationsförderung und der Wahrung der Rechte des Einzelnen. Die KI-Verordnung ordnet KI-Anwendungen in vier Risikostufen ein, für die jeweils andere Absicherungs- und/oder Transparenzanforderungen gestellt werden.

KI-Risikopyramide von Fraunhofer IAIS (CC BY-SA) -

Praxisübung (Modul 3): Multiple Choice Quizz 💬

-