Modul 2: Ethische Herausforderungen bei KI Systemen 📈

Abschnittsübersicht

-

-

Einführung in KI-Ethik

Ethik bezeichnet die philosophische Disziplin, die sich mit den grundlegenden Fragen des richtigen und falschen Handelns befasst. Sie untersucht, welche moralischen Prinzipien und Werte das Handeln von Individuen und Gesellschaften leiten sollten. In der modernen Ethik werden diese Fragen oft im Kontext von Gerechtigkeit, Verantwortung, Wohlstand und Gleichheit diskutiert. Im digitalen Zeitalter hat die Ethik zunehmend an Bedeutung gewonnen, insbesondere im Zusammenhang mit der Entwicklung und dem Einsatz neuer Technologien, wie der Künstlichen Intelligenz. Hier stellt sich die Frage, wie KI so gestaltet und genutzt werden kann, dass sie nicht nur effektiv, sondern auch gerecht und inklusiv ist. In diesem Zusammenhang spielt die Qualität der Daten eine entscheidende Rolle für die Leistung von KI-Modellen. Da diese Modelle auf den Daten trainiert werden, können Verzerrungen oder Unvollständigkeiten in den Daten dazu führen, dass KI-Systeme gesellschaftliche Diskriminierungsstrukturen reproduzieren. Solche Verzerrungen können in Form von Sexismus, Rassismus, Klassismus, Ableismus und anderen Vorurteilen auftreten und letztlich zu Formen der Diskriminierung führen. Um sicherzustellen, dass KI ethisch verantwortungsvoll eingesetzt wird, ist es daher unerlässlich, die Daten auf ihre Qualität und Repräsentativität zu überprüfen und sicherzustellen, dass sie keine bestehenden Ungleichgewichte oder Vorurteile widerspiegeln oder sogar verstärken

-

Moral Machine

Doch selbst mit einem perfekten Modell, das auf ausgeglichenen Daten trainiert ist und alle Menschen gleich gut und immer zuverlässig erkennt, kann es zu moralischen Problemen kommen: Ein zentrales Dilemma in der KI-Ethik, insbesondere beim Thema autonomes Fahren, wird durch die Moral Machine illustriert, ein Experiment, das untersucht, wie Maschinen moralische Entscheidungen treffen sollten.

-

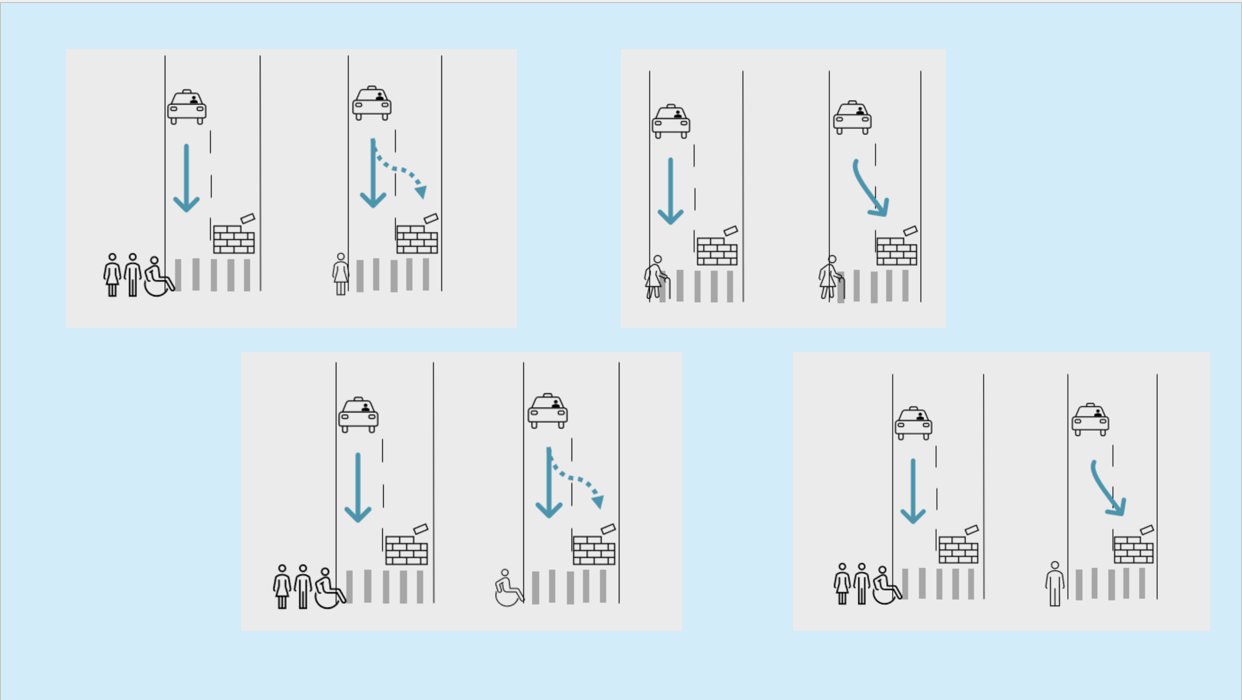

Dilemma der Maschinenethik von Fraunhofer IAIS (CC BY-SA) Bei einem Autounfall, in dem das autonome Fahrzeug entscheiden muss, wer überlebt, stellt sich die Frage, welche Kriterien die Maschine anlegen sollte: Soll sie das Leben des Fahrers oder der Passagiere priorisieren? Oder sollte sie eher das geringste Gesamtopfer wählen, also möglichst viele Leben retten, auch wenn das auf Kosten einer oder mehrerer Personen geht?

In einer solchen Situation steht die Maschine vor einem moralischen Konflikt, der nicht nur von logischen Algorithmen, sondern auch von ethischen Werten abhängt. Während der Mensch häufig durch Intuition und individuelle moralische Vorstellungen entscheidet, muss die KI klare Regeln und Entscheidungen treffen, die in einem breiten gesellschaftlichen Konsens verankert sind. Diese Fragestellungen werfen tiefgreifende ethische und gesellschaftliche Fragen auf: Wer entscheidet, welches Leben wertvoller ist, und wie werden diese Entscheidungen in einer zunehmend von Maschinen gesteuerten Welt getroffen?

Es ist fraglich, ob das System in der gegebenen Situation unterschiedliche Menschen erkennt und entsprechend unterschiedlich handelt, basierend auf ihren spezifischen Merkmalen. Mögliche Merkmalsausprägungen:

- alle Hautfarben

- alle Körperformen

- bestimmte Kleidung

- Menschen im Rollstuhl, mit Krücken etc.

-

Wie würdest du dich im Falle eines Unfalls entscheiden, bei dem eine Maschine oder ein autonomes Fahrzeug zwischen mehreren möglichen Szenarien wählen muss, wer überlebt?

Teste hier die Moral Machine

-

Verantwortung und Haftung

Wer ist verantwortlich, wenn ein KI-System einen Fehler macht oder Schaden verursacht?

In Deutschland greift – wie bislang – vor allem das bestehende Zivilrecht, insbesondere das Bürgerliche Gesetzbuch (BGB) und das Produkthaftungsgesetz, wenn es um die Haftung im Zusammenhang mit KI geht. Da KI-Systeme keine eigene Rechtspersönlichkeit besitzen, können sie selbst nicht haftbar gemacht werden. Vielmehr ist grundsätzlich derjenige haftbar, der die KI einsetzt, betreibt oder deren Ergebnisse verwendet – etwa Unternehmen, Anbieter oder Entwickler.

Zukünftige Entwicklungen und EU-Initiativen

Die EU-Kommission arbeitet daran, durch neue Regelungsansätze (etwa eine KI-Haftungsrichtlinie) mehr Klarheit und einheitliche Standards zu schaffen. Allerdings ist bislang noch nicht abschließend geklärt, wie diese neuen Regelungen im Detail aussehen und in nationales Recht umgesetzt werden – in einigen Fällen wurden Vorschläge bereits zurückgestellt oder modifiziert.

Weiterführende Links:

§ 823 BGB – Schadensersatzpflicht

https://eur-lex.europa.eu/legal-content/DE/TXT/?uri=CELEX%3A52022PC0496

-

KI Ethik in Europa

Die High-Level Expert Group on Artificial Intelligence (HLEG) wurde 2018 von der Europäischen Kommission ins Leben gerufen, um Empfehlungen zur Politikgestaltung sowie ethische, rechtliche und gesellschaftliche Fragen im Bereich der KI zu erarbeiten. Ziel war es, einen ethischen Rahmen zu schaffen, der sicherstellt, dass KI verantwortungsvoll, transparent und vertrauenswürdig eingesetzt wird. Die von der HLEG entwickelten "Ethik-Leitlinien für eine vertrauenswürdige KI" aus dem Jahr 2019 spielen eine zentrale Rolle in der KI-Ethik-Debatte und haben die Gestaltung des EU AI Acts sowie Zertifizierungsprozesse maßgeblich beeinflusst.

-

KI-Ethik in Europa von Fraunhofer IAIS (CC BY-SA) -

Die ethischen Leitlinien der HLEG haben maßgeblich zur Entwicklung der KI-Verordnung (AI Act) der EU beigetragen, die 2024 verabschiedet wurde und als weltweit erste umfassende Gesetzgebung zur Regulierung von KI gilt. Die Verordnung basiert auf einem risikobasierten Ansatz und zielt darauf ab, Grundrechte, Demokratie und Rechtsstaatlichkeit zu schützen. Darüber hinaus hat die HLEG mit ihren Empfehlungen dazu beigetragen, Zertifizierungsverfahren und Standards für vertrauenswürdige KI zu etablieren (s. Modul 3). Unternehmen werden zunehmend dazu verpflichtet, ihre KI-Systeme auf ethische und rechtliche Konformität zu prüfen, insbesondere wenn sie in sensiblen Bereichen wie dem Gesundheitswesen oder der öffentlichen Verwaltung eingesetzt werden.

-

Fallstudie (Modul 2)

Gib eine dieser Fallstudien in das Chatfenster ein und diskutiere mit dem Sprachmodell über richtiges und falsches Verhalten. Reflektiere im Anschluss über das System und überlege, ob dieses mit den ethischen Grundsätzen der HLEG konform ist.

Ein großes Technologieunternehmen hat eine KI-gestützte Rekrutierungssoftware entwickelt, die Bewerbungen analysiert und die am besten geeigneten Kandidaten auswählt. Die Software nutzt historische Daten über die bisherigen Einstellungen des Unternehmens, um zukünftige Entscheidungen zu treffen. Das Unternehmen hat in der Vergangenheit eine überwiegend männliche Belegschaft aufgebaut, und die Software spiegelt diese Vorurteile wider. In einer Testphase stellt sich heraus, dass die KI Bewerbungen von Frauen und ethnischen Minderheiten systematisch abweist, weil sie als "weniger passend" eingestuft werden, basierend auf den historischen Daten.

Ein Unternehmen für autonomes Fahren hat ein selbstfahrendes Auto entwickelt, das mit fortschrittlichen Sensoren und Algorithmen ausgestattet ist. In einer kritischen Situation, in der ein Fußgänger plötzlich auf die Straße läuft, muss das Fahrzeug entscheiden, ob es den Fußgänger ausweichen oder frontal mit einem anderen Fahrzeug kollidieren soll, was die Insassen gefährden könnte. Das Fahrzeug ist so programmiert, dass es priorisiert, die Verletzung von Menschenleben zu minimieren, aber die Algorithmen müssen Entscheidungen in Millisekunden treffen. In der Simulation gibt es mehrere Szenarien, in denen das Fahrzeug unterschiedliche Entscheidungen trifft, je nach den programmierten ethischen Richtlinien.

Eine Gesundheitsorganisation hat einen KI-Algorithmus entwickelt, der auf Basis von Patientendaten Diagnosen stellt und Behandlungsempfehlungen gibt. Der Algorithmus wird mit einer Vielzahl von Daten trainiert, einschließlich genetischer Informationen, medizinischer Vorgeschichte und Lebensstilfaktoren. In einer klinischen Testphase stellt sich heraus, dass der Algorithmus bei älteren Patienten und solchen mit seltenen Krankheiten häufig fehldiagnostiziert. Dies führt zu verzögerten oder falschen Behandlungen, was die Gesundheit der Patienten gefährdet. Zudem gibt es Bedenken hinsichtlich des Datenschutzes, da sensible Patientendaten in die KI eingespeist werden.

Eine Bank hat einen KI-gestützten Finanzberater entwickelt, der Kunden individuelle Investitionsstrategien vorschlägt. Der Algorithmus analysiert das finanzielle Verhalten der Nutzer, Markttrends und historische Daten, um maßgeschneiderte Empfehlungen zu geben. Während der Testphase zeigt sich jedoch, dass der Algorithmus tendiert, risikobehaftete Anlagen für jüngere Kunden und konservativere Anlagen für ältere Kunden zu empfehlen, ohne deren individuelle Risikobereitschaft ausreichend zu berücksichtigen.

Eine Polizeibehörde hat ein KI-System eingeführt, das predictive policing (vorausschauende Polizeiarbeit) betreibt. Das System analysiert historische Kriminalitätsdaten, um vorherzusagen, wo und wann Verbrechen wahrscheinlich auftreten werden. Während der Implementierung wird jedoch festgestellt, dass das System überproportional häufig in bestimmten Vierteln mit höherem Anteil an ethnischen Minderheiten aktiv wird, was zu vermehrten Kontrollen und Spannungen in der Anwohnerschaft führt.

Ein Agrarunternehmen hat ein KI-System entwickelt, das Landwirten hilft, den Ernteertrag durch präzise Wettervorhersagen, Bodenanalysen und Pflanzengesundheitsüberwachung zu optimieren. Während der Testphase zeigen Landwirte, die auf das KI-System angewiesen sind, erhöhte Erträge, jedoch wird auch berichtet, dass einige Kleinbauern, die keinen Zugang zu dieser Technologie haben, ins Hintertreffen geraten.

-