Du bist aktuell im Gastmodus. Logge dich ein oder registriere dich, um die HOOU-Plattform komplett zu nutzen.

- Nutze alle Lernfunktionen, wie Tests, Quizze und Umfragen.

- Schreibe Beiträge und tausche dich in unseren Foren aus.

- In einigen Lernangeboten bestätigen wir dir die Teilnahme.

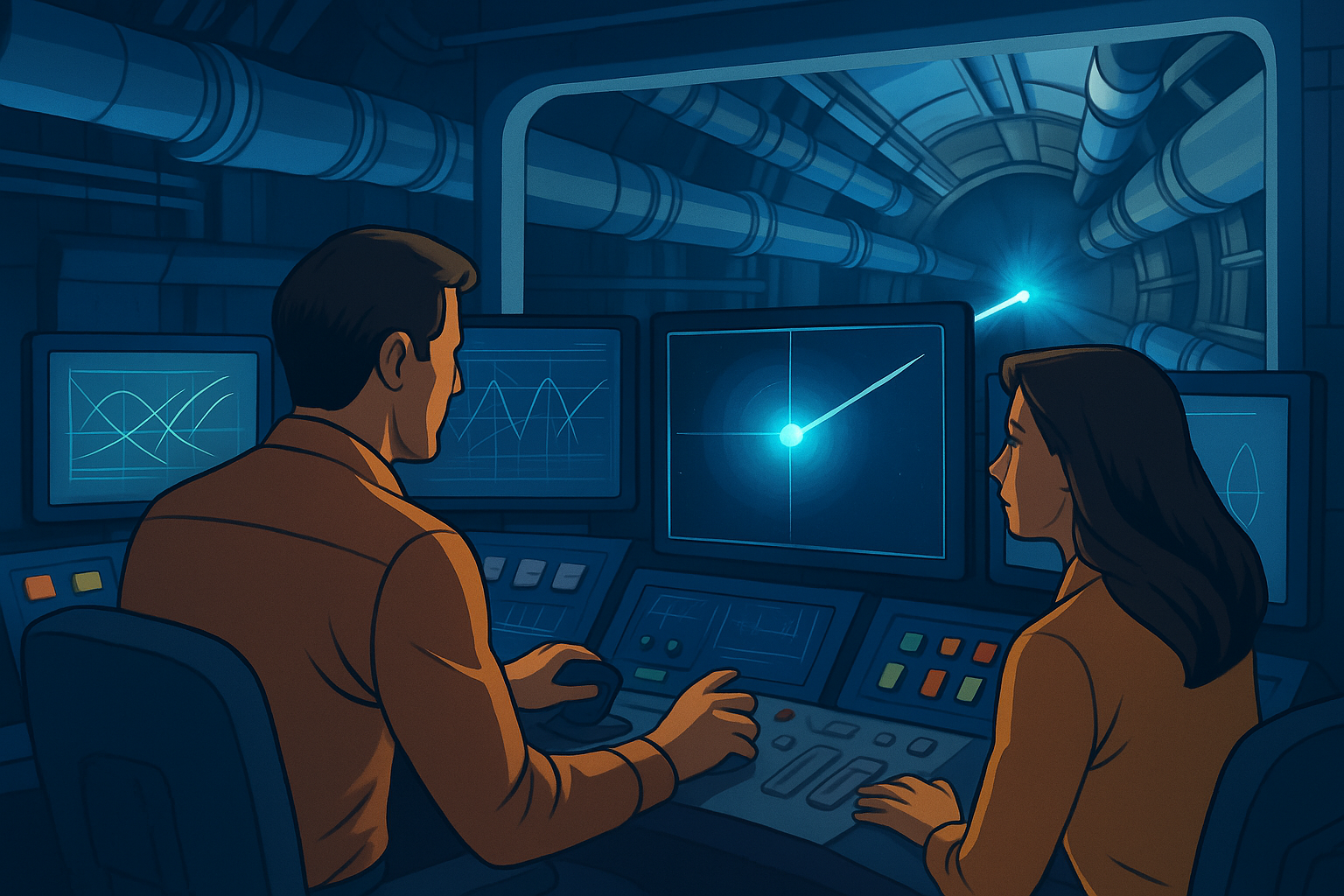

AI for Autonomous Particle Accelerators

Abschnittsübersicht

-

-

-

-

-

-

Teilchenbeschleuniger haben einen grossen Nutzen für unsere Gesellschaft im Bereich Grundlagenforschung aber auch für ganz aktuelle und praktische Herausforderungen. Teilchenbeschleuinger sind hoch komplexe Grossgeräte, welche von Experten_innen_ mit langjähriger Erfahrung betrieben werden. Aktuell wird an AI-Unterstützung für den Betrieb geforscht um bessere Präzision und Zuverlässigkeit zu erreichen und dadurch die Leistungsfähigkeit von Beschleunigeranlagen zu steigern und neue wissenschaftliche Erkenntnisse zu ermöglichen.