Darum geht es - Herausforderungen und Risiken

| Website: | Hamburg Open Online University |

| Kurs: | KI im Studium nutzen |

| Buch: | Darum geht es - Herausforderungen und Risiken |

| Gedruckt von: | Gast |

| Datum: | Dienstag, 3. Februar 2026, 00:42 |

1. Wie gefährlich ist KI?

Das Video beleuchtet die rapide Entwicklung und Potenziale der künstlichen Intelligenz (KI). Es beginnt mit historischen Meilensteinen wie Deep Blue, der den Schachweltmeister besiegte, und AlphaGo, der im komplexen Spiel Go triumphierte. Es betont die Überlegenheit von KIs in Spielen wie Quake 3 und Dota 2, sowohl im Einzel- als auch im Teamspiel.

Trotz dieser Erfolge sind KIs Fachidioten, brillant in ihrem Bereich, aber eingeschränkt in anderen. Der Mensch übertrifft sie noch in intuitivem Lernen, obwohl KIs schneller aus großen Datenmengen lernen können. Experten prognostizieren, dass KIs irgendwann die menschliche Intelligenz übersteigen könnten, womöglich schon im aktuellen Jahrhundert.

Die Anwendungsgebiete von KI sind breit gefächert: von Medizin über Militär bis hin zur Finanzbranche und Journalismus. Dabei existieren aktuelle Beispiele wie autonome Fahrzeuge, Roboter und Spracherkennung.

Jedoch stoßen KIs an Grenzen bei der emotionalen Intelligenz, da sie Emotionen erkennen, aber nicht fühlen können. Das wirft ethische Fragen auf, die von einer speziellen Datenethikkommission untersucht werden.

Die Debatte um KI ist kontrovers: von der potenziellen Gefahr autonomer Waffen bis hin zur Angst vor massiven Arbeitsplatzverlusten. Es gibt divergierende Meinungen über die Auswirkungen auf die Gesellschaft.

Letztlich liegt die Verantwortung für die Entwicklung und den Einsatz von KI beim Menschen. Es wird deutlich, dass trotz der großen Möglichkeiten, KI auch große Gefahren birgt, die sorgfältig betrachtet werden müssen.

KI - Macht - Ungleichheit

Rainer Mühlhoff thematisiert in seinem Vortrag wie KI die soziale Dimension von Nachhaltigkeit gefährdet. Sieh Dir das Video gern an - der Vortrag ist mit ca. 40 Minuten lang aber sehr sehenswert.KI birgt das Risiko der weltweiten Ausbeutung von natürlichen und sozialen Ressourcen. Um KI nachhaltiger zu gestalten, müssen wir gegen algorithmische Diskriminierung, soziale Selektion und digitale Arbeitsausbeutung vorgehen. In Diskussionen über KI und Nachhaltigkeit wird oft der Ressourcenverbrauch kritisiert, jedoch dürfen wir die sozialen Dimensionen nicht übersehen. Sieben der UN-Nachhaltigkeitsziele betonen Gleichheit, Anti-Diskriminierung, Bildungszugang und den Abbau von Ungleichheit. KI-Systeme neigen nicht nur zu Bias und Diskriminierung, sondern basieren auch auf sozialer und wirtschaftlicher Ausbeutung. Nutzer:innen werden als Datenlieferant:innen und Gig-Arbeiter:innen als günstige Arbeitskräfte genutzt. Durch Datenfizierung und Ausnutzung ökonomischer Machtgefälle entsteht eine Problematik, die von der Google-Suche bis zu ChatGPT reicht. KI-Unternehmen profitieren von niedrigen Arbeitsschutzstandards und Löhnen in anderen Ländern, was zu Krankheiten und prekären Arbeitsbedingungen führt. Eine effektive Regulierung erfordert die Betrachtung von KI-Systemen als soziotechnische Systeme, um der globalen Zunahme von Ungleichheit und Ausbeutung durch KI entgegenzuwirken.

2. Wie gefährlich bist Du, ChatGPT?

Fragt man ChatGPT: »Was sind Herausforderungen und Risiken von KI« kommt folgende Antwort:

»Künstliche Intelligenz (KI) bietet viele Möglichkeiten und Potenziale, birgt jedoch auch Herausforderungen und Risiken. Hier sind einige der wichtigsten:

Herausforderungen:

1. Ethik und Verantwortung: Die Entwicklung von KI wirft ethische Fragen auf, insbesondere im Hinblick auf Datenschutz, Diskriminierung, Transparenz und Verantwortlichkeit von Entscheidungen, die von KI-Systemen getroffen werden.

2. Arbeitsplatzverlust: KI-Technologien könnten bestimmte Arbeitsplätze ersetzen, insbesondere solche, die repetitive Aufgaben oder einfache Berechnungen erfordern. Dies könnte zu sozialen und wirtschaftlichen Ungleichheiten führen.

3. Bias und Diskriminierung: KI-Modelle können aufgrund von unbeabsichtigten Voreingenommenheiten in den Trainingsdaten oder Algorithmen diskriminierende Entscheidungen treffen und bestehende Vorurteile verstärken.

4. Datenschutz und Sicherheit: Die Verwendung großer Datenmengen für das Training von KI-Modellen birgt Datenschutz- und Sicherheitsrisiken. Unbefugter Zugriff auf sensible Informationen oder das Missbrauchen von KI-Systemen sind potenzielle Bedenken.

5. Mangelnde Transparenz: Einige KI-Modelle, insbesondere neuronale Netzwerke, sind oft schwer zu verstehen, wie sie zu ihren Entscheidungen gelangen. Dies kann das Vertrauen in KI-Systeme beeinträchtigen.

Risiken:

1. Superintelligenz: Ein hypothetisches Szenario, in dem KI-Systeme menschliche Intelligenz übertreffen könnten, was zu unvorhersehbaren Folgen führen könnte, wenn die Systeme außer Kontrolle geraten.

2. Autonome Waffen: Die Entwicklung von autonomen Waffensystemen könnte zu ungewollten Eskalationen führen oder die menschliche Kontrolle über gefährliche Situationen verlieren lassen.

3. Arbeitslosigkeit: Die Automatisierung durch KI könnte zu einem erheblichen Arbeitsplatzverlust in bestimmten Branchen führen, was soziale Spannungen und wirtschaftliche Instabilität verursachen könnte.

4. Manipulation und Fehlinformation: KI-Technologien könnten zur Verbreitung von Fehlinformationen, gefälschten Medien oder Deepfakes verwendet werden, die die Wahrnehmung der Realität verzerren könnten.

5. Abhängigkeit von KI: Wenn Gesellschaften zu abhängig von KI-Systemen werden, könnten sie anfällig für Störungen oder Angriffe auf diese Systeme sein.

Um diese Herausforderungen und Risiken anzugehen, ist es wichtig, dass die Entwicklung und Implementierung von KI-Technologien von einer umfassenden ethischen und gesetzlichen Rahmenarbeit begleitet werden. Die internationale Zusammenarbeit bei der Gestaltung von KI-Richtlinien und -Standards ist ebenfalls von großer Bedeutung, um sicherzustellen, dass KI zum Wohl der Menschheit eingesetzt wird.« (ChatGPT 3.5, 14.08.2023)

3. Gefahren von Fehlinformationen und Deep Fakes

Die Risiken und Gefahren durch Fehlinformationen, gefälschte Medien und Deep Fakes diskutiert Markus Lanz im folgenden Video mit Gästen.

In dem Gespräch über die Rolle der Medien und die Herausforderungen der Wahrheit diskutierten die Teilnehmenden die Verwendung und Manipulation von Bildern, insbesondere im Kontext gefälschter Bilder, die scheinbar Ereignisse zeigen, die nie stattgefunden haben. Es herrschte Einigkeit darüber, dass der gesunde Menschenverstand eine wichtige Rolle spielt, um die Authentizität von Bildern zu hinterfragen. Die Debatte betonte auch die zunehmende Schwierigkeit, zwischen echten und gefälschten Inhalten zu unterscheiden, insbesondere da Technologie wie Deepfakes immer anspruchsvoller und zugänglicher wird.

Journalistische Standards und Prüfverfahren müssen sich anpassen, wobei Experten und Expertinnen und forensische Analyse eine größere Rolle spielen. Es wurde betont, dass bei bedeutenden Fällen von Fälschungen die finanziellen Mittel für umfassende Überprüfungen oft fehlen können. Es besteht die Sorge, dass die Dynamik der Technologie und die Geschwindigkeit, mit der Fälschungen erstellt werden können, die Möglichkeit der schnellen Identifizierung und Aufklärung solcher Fälle beeinträchtigen.

Die Diskussion ging über gefälschte Bilder hinaus und bezog sich auch auf Deepfake-Videos, die politische Verwirrung und Misstrauen schüren könnten. Ein Beispiel war ein gefälschtes Gespräch zwischen politischen Persönlichkeiten, das das Vertrauen in internationale Partner erschütterte. Es wurde betont, dass die wachsende Raffinesse von Manipulationstechniken eine reale Bedrohung für die Gesellschaft darstellt und dass politische Entscheidungsträger stärker auf ihre Vertrauenswürdigkeit achten müssen.

Es gab auch Besorgnis darüber, dass subtile Manipulationen, wie zum Beispiel das Bearbeiten von Fotos, um politische Botschaften zu senden, eine weitreichendere und subtilere Wirkung haben könnten, indem sie falsche oder manipulierte Informationen transportieren, die sich schwerer entlarven lassen. Es wurde hervorgehoben, dass die Schwierigkeit nicht nur darin liegt, Fälschungen zu erkennen, sondern auch darin, dass diese Manipulationen bereits wirksam werden können, bevor sie entdeckt werden.

Wichtig sei mit einem Fokus auf die Verantwortung der Medien, die Wahrheit zu bewahren und die Öffentlichkeit aufzuklären. Es wurde die die Dringlichkeit betont, Medienkompetenz zu fördern, um in einer Welt von schnell entstehenden Fälschungen und Deepfakes kritisch zu bleiben.

In einer Diskussion über Desinformation und alternative Realitäten innerhalb der Gesellschaft wurde betont, dass das Phänomen des Glaubens an verschiedene Realitäten eine gesunde Gesellschaft bedrohen kann. Die Diskussion drehte sich um die Schwierigkeiten, dieses Problem in den Griff zu bekommen. Es wurden Äußerungen eines ehemaligen KGB-Offiziers zitiert, der die Verbreitung von Lügen als Mittel zur Desillusionierung betrachtete. Dieser Ansatz führt dazu, dass Menschen an nichts mehr glauben und somit kontrollierbar werden.

Die Diskussionsteilnehmenden brachten das Problem auf politischer Ebene und die Auswirkungen auf demokratische Systeme zur Sprache. Die Wichtigkeit von Bildung als entscheidendem Faktor im Umgang mit Desinformation wurde hervorgehoben. Es wurde darauf hingewiesen, dass Desinformation in weniger gebildeten Gemeinden stärker verfängt.

Die Idee, Technologie zu verwenden, um gefälschte Inhalte zu erkennen, wurde diskutiert, aber es wurde auch betont, dass das Problem nicht nur technischer Natur ist, sondern auch ein gesellschaftliches Phänomen. Die Notwendigkeit, mündige Individuen heranzubilden, um mit der Unsicherheit und Desinformation umzugehen, wurde als essenziell angesehen. Es herrschte Einigkeit darüber, dass das Bildungssystem darauf ausgerichtet sein sollte, Menschen zu ermächtigen und zu mündigen Bürgern zu machen.

Schließlich wurde die Sorge geäußert, dass die Kontrolle über solche Systeme in die falschen Hände geraten könnte und dass die Lösung in der Förderung von Resilienz liegt, anstatt in übermäßiger Kontrolle.

4. Welche Gefahren sieht die Wissenschaft

Wissenschaftler und Wissenschaftlerinnen (Weidinger et al.) haben 2021 folgende Herausforderungen und Risiken ausgemacht:

Diskriminierung, Ausgrenzung und Toxizität

Sprachmodelle reproduzieren Diskriminierungen, Ausgrenzungen, Stereotype und Toxizität, die in den Trainingsdaten der KI enthalten sind.

Gefährdung durch Information

Es kann zu Verletzungen der Privatsphäre und zu Sicherheitsrisiken kommen wenn die Sprachmodelle mit privaten, sensiblen und/oder sicherheitsrelevanten Daten trainiert wurden.

Fehlinformationen

Sprachmodelle können falsche und irreführende Informationen produzieren und Nutzende zu unethische oder illegale Handlungen anregen.

Böswillige Verwendungen

Nutzende können KIs nutzen um absichtlich Schäden anzurichten z.B. um Waffen zu bauen oder Cyberangriffe durchzuführen.

Schäden durch Mensch-Computer-Interaktion

Nutzende können Sprachmodelle vermenschlichen, dadurch falsch einschätzen und dem Modell übermäßig vertrauen was wiederum zu unsicherer Nutzung führen kann.

Automatisierung, Zugang und Umweltschäden

Der Einsatz von Sprachmodellen kann zu sozialen Ungleichheiten führen durch die ungleiche Verteilung von Vorteilen und Risiken. Es kann zum Verlust von Arbeitsplätzen führen. Der Betrieb von KIs kann Umweltschäden verursachen. KIs können die kreative Wirtschaft schwächen (Weidinger et al., 2021).

Quelle:

Weidinger, L., Mellor, J., Rauh, M., Griffin, C., Uesato, J., Huang, P.-S., Cheng, M., Glaese, M., Balle, B., Kasirzadeh, A., Kenton, Z., Brown, S., Hawkins, W., Stepleton, T., Biles, C., Birhane, A., Haas, J., Rimell, L., Hendricks, L. A., . . . Gabriel, I. (2021). Ethical and social risks of harm from Language Models. https://arxiv.org/pdf/2112.04359.pdf

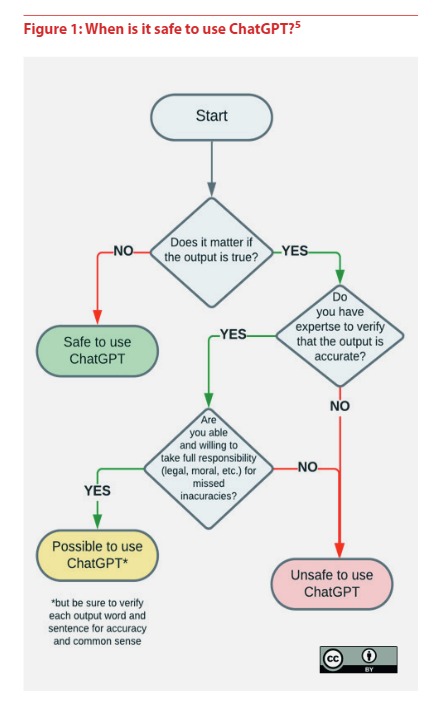

5. Möglichkeiten und Grenzen von ChatGPT

Aufgabe: Schau Dir das Video an und beantworte die darin gestellten Fragen.

[Video]. YouTube. https://www.youtube.com/watch?v=_ab6L50HlcI

KI-Systeme entwickeln sich rasant und verändern die Gesellschaft. Nicht nur Studierende nutzen die Technologie, um schnell Texte zu erstellen. Auch in Kunst, Kultur und Arbeitswelt wird über die Auswirkungen solcher KI-Systeme diskutiert.

6. KI-Ethik-Empfehlungen der UNESCO

In Anbetracht der potenziellen Risiken von KIs wie beispielsweise Chat-GPT ist es wichtig, sich mit ethischen Richtlinien für künstliche Intelligenz auseinanderzusetzen. Die UNESCO hat umfassende Empfehlungen entwickelt, die die ethische Verantwortung bei der Nutzung von KI betonen. Die UNESCO hat bereits ganzheitliche KI-Ethik-Empfehlungen formuliert, die in einem offenen und inklusiven Prozess ausgehandelt wurden. Sie sind Leitplanken für politische Entscheidungen. Der Fokus der Empfehlungen liegt neben menschenrechtlichen Verpflichtungen auch auf »blind spots« wie KI und Gender, KI und Bildung, KI und Nachhaltigkeit, KI und der Globale Süden (Entwicklung) sowie KI und Bildung. Sie fordern außerdem klare Verfahrens- und Transparenzpflichten (Kettemann, o. J.).

Die definierten Handlungsansätze für KI-Akteur*innen in Politik und Verwaltung sind zusammengefasst:

- KI muss Menschenrechte achten, sichern und fördern

- Ethische (und rechtliche) Leitplanken müssen im gesamten Lebenszyklus von KI-Systemen eingehalten werden

- KI-Daten müssen möglichst öffentlich verfügbar sein

- KI muss zu gesellschaftlicher Vielfalt beitragen

- KI muss öffentlich überwacht werden

- KI muss global zugänglich werden

- KI muss zur Realisierung der SDGs beitragen

- KI-Standards müssen in inklusiven Prozessen ausverhandelt werden (Kettemann, o. J.).

Quelle:

Kettemann, M. C. (o. J.). UNESCO-Empfehlung zur Ethik Künstlicher Intelligenz.: Bedingungen zur Implementierung in Deutschland. UNESCO. https://www.unesco.de/sites/default/files/2022-03/DUK_Broschuere_KI-Empfehlung_DS_web_final.pdf

7. Datenschutz und KI: Was Du beachten solltest

Wenn Du generative KI-Tools nutzen willst, ist es wichtig, ein paar Dinge zu berücksichtigen. Hier sind ein paar Tipps, die Dir dabei helfen:

1. Schutz Deiner Daten

Registrierung und Nutzung: Bei vielen KI Tools musst Du Dich für die Nutzung mit personenbezogenen Daten registrieren, um diese nutzen zu können wie z.B. mit Name und Vorname und einer Mailadresse, die Vorname und Nachname enthält. Möglicherweise bietet Deine Hochschule schon einen KI-Acount an, den Du auch ohne Registrierung nutzen kannst.

Die generative KI Perplexity sowie den Bing Chat/Copilot im Browser Edge kannst Du ohne Registrierung nutzen.

2. Sicherheit der Informationen

- Keine persönlichen Daten eingeben: Achte darauf, keine persönlichen Daten wie Namen, E-Mails, Telefonnummern, Adressen oder Bankdaten in die KI-Tools einzugeben, um Deine Sicherheit zu gewährleisten.

3. Geistiges Eigentum und Urheberrecht

- Überprüfung von Inhalten: Die von der KI generierten Inhalte sollten immer auf mögliche Urheberrechtsverletzungen überprüft werden, bevor sie weitergegeben oder veröffentlicht werden. Das bedeutet, dass die Verwendung eines KI-Tools Dich nicht von der Verantwortung entbindet, die zugrundeliegenden Quellen sorgfältig zu überprüfen und anzugeben.

- Uploads: Keine Dokumente, auf die kein freier Zugriff besteht, in KIs hochladen (z.B. ein Vorlesungsskript) bzw. dies nur mit Einwilligung des Urhebenden tun.

4. Verantwortung und Haftung

- Deine Verantwortung: Es ist wichtig zu beachten, dass die Verwendung von KI-Tools Verantwortung mit sich bringt. Du bist dafür verantwortlich, die Ergebnisse sorgfältig zu überprüfen und sie nicht zu nutzen, um andere zu täuschen oder zu irreführen.

Quellen:

Hochschule RheinMain. (26.05.23). Rechtliche Fallen bei der Verwendung von KI Tools an der Hochschule. https://www.hs-rm.de/fileadmin/Home/Services/Didaktik_und_Digitale_Lehre/Datenschutz_bei_KI-Tools.pdf

UNESCO. (2023). ChatGPT and Artificial Intelligence in higher education: Quick start guide. https://unesdoc.unesco.org/ark:/48223/pf0000385146

8. Zusammenfassung und Fazit

Wir haben nun umfassend die Herausforderungen und Risiken im Zusammenhang mit Künstlicher Intelligenz (KI) und speziell generativen KI-Tools wie ChatGPT beleuchtet:

Ethik und Verantwortung: KI wirft ethische Fragen zu Datenschutz, Diskriminierung und Verantwortlichkeit von Entscheidungen auf.

Arbeitsplatzverlust: Die Automatisierung durch KI könnte zu sozialen und wirtschaftlichen Ungleichheiten führen.

Bias und Diskriminierung: KI-Modelle könnten bestehende Vorurteile verstärken und diskriminierende Entscheidungen treffen.

Datenschutz und Sicherheit: Die Verwendung großer Datenmengen für KI birgt Datenschutz- und Sicherheitsrisiken.

Mangelnde Transparenz: Einige KI-Modelle sind schwer zu verstehen, was das Vertrauen beeinträchtigen könnte.

Superintelligenz: Die Möglichkeit, dass KI-Systeme außer Kontrolle geraten, ist eine potenzielle Gefahr.

Autonome Waffen: Die Entwicklung solcher Waffen könnte die menschliche Kontrolle über gefährliche Situationen verlieren lassen.

Fehlinformationen und Manipulation: KI-Technologien könnten falsche Informationen verbreiten und die Wahrnehmung der Realität verzerren.

Abhängigkeit von KI: Gesellschaften, die zu abhängig von KI-Systemen werden, könnten anfällig für Störungen oder Angriffe sein.

Empfehlungen und Vorsichtsmaßnahmen: Die UNESCO hat Richtlinien formuliert, und es wird empfohlen, verantwortungsvoll mit generativen KI-Tools umzugehen.

Folgende Fragen stellen sich:

Wie können wir zukünftig mit den Risiken von Künstlicher Intelligenz umgehen und welche Maßnahmen müssen ergriffen werden, um potenzielle Gefahren zu verhindern?

Inwiefern beeinflusst die Entwicklung von Sprachmodellen den Bildungsbereich und welche Herausforderungen ergeben sich daraus? Darum wird es im nächsten Kapitel gehen. Doch zunächst beantworte bitte kurz im Forum die Frage: Was denkst Du: sollte KI in der Lehre einsetzt werden? Was spricht Deiner Meinung nach dafür und was dagegen?